Inhalt

Als im November 2022 OpenAI einen öffentlichen Zugang zu seinem Chat-Inferface chatGPT einrichtete, wurde weiten Kreisen der Öffentlichkeit erstmals klar, in welchem Entwicklungsstadium große Sprachmodelle (Large Language Models, LLMs) inzwischen angekommen sind. Seitdem haben andere Firmen (Microsoft, Google, Anthropic, Meta) mit (zumindest zum Teil) frei nutzbaren Systemen nachgezogen. Die Entwicklung derartiger Systeme kann schon jetzt als disruptiv gelten und bleibt weiterhin überaus dynamisch, journalistische und wissenschaftliche Einordnungen können kaum Schritt halten.

Für Aufgaben, die in der Forschung anfallen, auch im Bereich der Digital Humanities, schließen LLM-basierte Ansätze hinsichtlich der Performance zunehmend zu "traditionelleren" Ansätzen auf, teilweise erreichen sie schon bessere Benchmarks. Allerdings ist der Einsatz solcher Systeme in Forschungsprozessen, die replizierbar bzw. reproduzierbar sein sollten, mit einer Reihe von Fragezeichen versehen. Das gilt v.a. dort, wo man als Forscher*in keinen Einfluss auf die Konsistenz der dahinterliegenden Modelle hat. OpenAI kann jederzeit Änderungen an den Modellen durchführen, die über die zur Verfügung stehenden Interfaces nutzbar sind. Ein Ansatz ist hier der Einsatz von frei zur Verfügung stehenden LLM-Modellen, die man auf eigener Hardware laufen lassen kann, und so deren Konsistenz selbst sicherstellt.

Ziel dieser Übung ist es, zu einer Übersicht über den Bereich OpenLLMs zu kommen, ihre Grundlagen zu verstehen, sowie die Fähigkeiten der verfügbaren Systeme im Vergleich zu den kommerziellen LLMs zu testen. Von den Teilnehmer:innen wird verlangt, dass sie die angegebene Literatur zu den einzelnen Sitzungen lesen und im Kreis der Übung mit den anderen diskutieren. Für die Vorstellung verfügbarer OpenLLMs und den Test von Anwendungsszenarien werden Gruppen gebildet, die gemeinsam Präsentationen erarbeiten und vorstellen. Programmierkenntnisse sind nur für bestimmte Gruppen notwendige Voraussetzung.

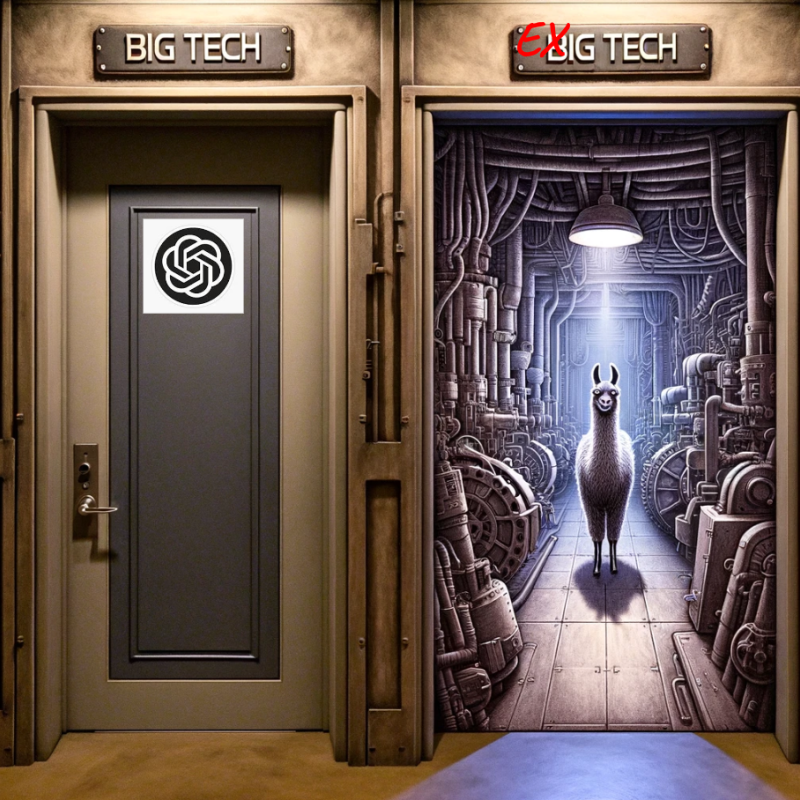

Teaser-Bild: Nachbearbeitetes Bild (Output von Dall-e https://openai.com/product/dall-e-2) auf die Eingabe "I would like a picture of a corridor with two doors, one on the left side that looks firmly closed and one on the right side that is open and where you can see that it leads into an engine room. There is a llama engraved on the open door and the text "BIG TECH" on the closed door." und "Very good, now remove the llama from the door and place it in the engine room.", da Lama auch auf der Big-Tech-Tür gelandet war. Dass mir Dall-e das Logo von OpenAI ausgibt hatte ich durch mehrere Versuchen davor aufgegeben und es nachträglich hinzugefügt. Da über beiden Türen Big Tech stand habe ich das eine (historisch auch mehr oder weniger richtig) ge-Ex-t.

Organisatorisches

Die Übung findet jeden Donnerstag von 14-15:30 in Präsenz statt, Ausnahmen spezifiziert der Seminarplan.

Studienleistung (obligatorisch):

In den Sitzungen mit Plenum-Format wird als Vorbereitung das Studium der angegebenen Literatur eine aktive Beteiligung an den Diskussionen verlangt (dies ist nur bei Anwesenheit möglich).

In den Sitzungen mit Referaten stellen die Teilnehmer:innen ihre Ergebnisse vor. Alle Teilnehmer:innen müssen

a) einer Gruppe angehören, die in der vierten Sitzung ein OpenLLM vorstellt

b) im weiteren Verlauf der Übung ein Anwendungsszenario ausarbeiten und in einer der Sitzungen ab Mitte/Ende Juni vorstellen.

Prüfungsleistung (fakultativ): Vertiefung, Dokumentation

Es ist möglich, in Verbindung mit der Übung eine Prüfung in den Modulen AM2 (Angewandte Softwaretechnologie, nur Prüfungsordnung von 2015) oder EM2 (Digital Humanities) abzulegen. Im Normalfall schließt sich die Prüfungsleistung an die Studienleistung an, indem Sie die dort erarbeiteten Projekte vertieft bzw. weiterentwickelt und stärker dokumentiert. Die Erarbeitung der Prüfungsleistung erfolgt bis Mitte September 2024.

Seminarplan (Stand 04/2024 - wird ggfs. noch angepasst)

|

|

|

|

|

|

|

|

Organisatorisches |

Plenum |

||

|

|

LLMs: Grundlagen |

Plenum |

Huang (2023) Shanahan (2024) Wolfram (2023) |

|

|

|

LLMs: Probleme |

Plenum |

Shapira et al. (2024) Balloccu et al. (2024) |

|

|

|

Vorstellung gängiger (Open)LLMs |

Referate |

Zhao et al. (2023) Liesenfeld et al. (2023) |

|

|

|

||||

|

|

Projekte: Anforderungen |

Plenum |

Battle et al. (2024) Liu et al. (2023) |

|

|

|

||||

|

|

||||

|

|

Projekte: Erste Statusberichte |

Plenum |

||

|

|

(Projektarbeit) |

online |

||

|

|

(Projektarbeit) |

online |

||

|

|

Projektberichte I |

Referate |

||

|

|

Projektberichte II |

Referate |

||

|

|

Projektberichte III |

Referate |

||

|

18.7.2024 |

Zusammenfassung, Ausblick |

Plenum |

Links (Wird noch aktualisiert!)

Interfaces zu ClosedSource-Sparchmodellen:

- ChatGPT (OpenAI): https://chat.openai.com/ (kostenfreies Interface zu GPT-3.5 und – für 20$/Monat – GPT-4)

- Bing (Microsoft): https://www.bing.com/ (kostenfreies Interface zu – wenn man Glück hat – GPT-4)

- Claude (Anthropic) https://claude.ai/ (Momentan nicht aus Europa erreichbar)

- Perplexity (Perplexity) https://www.perplexity.ai/ (bezeichnet sich selbst als "Antwortmaschine", hat mit Bezahlaccount Zugriff u.a. auf Claude 3)

- Gemini (Google) https://gemini.google.com/ (kostenfreies Interface zu Gemini, dem relativ neuen Sprachmodell von Google)

- [Luminous (Aleph Alpha): https://www.aleph-alpha.com/ (hier war mal ein Interface, das ist aber verschwunden...)]

Open LLMs:

- LLAMA 2 (Meta) https://llama.meta.com/

- Mistral (Mistral AI) https://docs.mistral.ai/

- Gemma (Google) https://ai.google.dev/gemma

- Sammlung von Models auf Huggingface: https://huggingface.co/models

Bilder / Präsentationen / Demos:

- LLM Glossay (Draft) von Tessa Gengnagel, Fotis Jannidis, Rabea Kleymann, Julian Schröter, Heike Zinsmeister (verbunden mit einem Panel auf der DHd2024)

- Video "Intro to lange language models" von Andrej Karpathy (Youtube)

- Transformer Architecture

- ChatGPT Architecture

- Word Embeddings Demo: https://www.cs.cmu.edu/~dst/WordEmbeddingDemo/

- Good old Machine Learning (Präsentation vom MLDay 2018)

- Beispielprojekt: LLMTestSubjects

Literatur (Wird noch aktualisiert!)

Alizadeh, M., Kubli, M., Samei, Z., Dehghani, S., Bermeo, J. D., Korobeynikova, M., & Gilardi, F. (2023). Open-Source Large Language Models Outperform Crowd Workers and Approach ChatGPT in Text-Annotation Tasks (arXiv:2307.02179). arXiv. http://arxiv.org/abs/2307.02179

Balloccu, S., Schmidtová, P., Lango, M., & Dusek, O. (2024). Leak, Cheat, Repeat: Data Contamination and Evaluation Malpractices in Closed-Source LLMs. In Y. Graham & M. Purver (Hrsg.), Proceedings of the 18th Conference of the European Chapter of the Association for Computational Linguistics (Volume 1: Long Papers) (S. 67–93). Association for Computational Linguistics. https://aclanthology.org/2024.eacl-long.5

Battle, R., & Gollapudi, T. (2024). The Unreasonable Effectiveness of Eccentric Automatic Prompts (arXiv:2402.10949). arXiv. https://doi.org/10.48550/arXiv.2402.10949

Chen, H., Jiao, F., Li, X., Qin, C., Ravaut, M., Zhao, R., Xiong, C., & Joty, S. (2024). ChatGPT’s One-year Anniversary: Are Open-Source Large Language Models Catching up? (arXiv:2311.16989). arXiv. https://doi.org/10.48550/arXiv.2311.16989

Huang, H. (2023, Januar 30). The generative AI revolution has begun—How did we get here? Ars Technica. https://arstechnica.com/gadgets/2023/01/the-generative-ai-revolution-has-begun-how-did-we-get-here/

Huang, L., Yu, W., Ma, W., Zhong, W., Feng, Z., Wang, H., Chen, Q., Peng, W., Feng, X., Qin, B., & Liu, T. (2023). A Survey on Hallucination in Large Language Models: Principles, Taxonomy, Challenges, and Open Questions (arXiv:2311.05232). arXiv. http://arxiv.org/abs/2311.05232

Jin, C., & Rinard, M. (2023). Evidence of Meaning in Language Models Trained on Programs (arXiv:2305.11169). https://doi.org/10.48550/arXiv.2305.11169

La Cava, L., Costa, D., & Tagarelli, A. (2024). Open Models, Closed Minds? On Agents Capabilities in Mimicking Human Personalities through Open Large Language Models (arXiv:2401.07115). arXiv. https://doi.org/10.48550/arXiv.2401.07115

Liesenfeld, A., Lopez, A., & Dingemanse, M. (2023). Opening up ChatGPT: Tracking openness, transparency, and accountability in instruction-tuned text generators. Proceedings of the 5th International Conference on Conversational User Interfaces, 1–6. https://doi.org/10.1145/3571884.3604316

Liu, P., Yuan, W., Fu, J., Jiang, Z., Hayashi, H., & Neubig, G. (2023). Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing. ACM Comput. Surv., 55(9), Article 9. https://doi.org/10.1145/3560815

Piantadosi, S. T., & Hill, F. (2022). Meaning without reference in large language models (arXiv:2208.02957). arXiv. https://doi.org/10.48550/arXiv.2208.02957

Shanahan, M. (2024). Simulacra as Conscious Exotica (arXiv:2402.12422). arXiv. https://doi.org/10.48550/arXiv.2402.12422

Shapira, N., Levy, M., Alavi, S. H., Zhou, X., Choi, Y., Goldberg, Y., Sap, M., & Shwartz, V. (2024). Clever Hans or Neural Theory of Mind? Stress Testing Social Reasoning in Large Language Models. In Y. Graham & M. Purver (Hrsg.), Proceedings of the 18th Conference of the European Chapter of the Association for Computational Linguistics (Volume 1: Long Papers) (S. 2257–2273). Association for Computational Linguistics. https://aclanthology.org/2024.eacl-long.138

Sher, S. (2023, April 21). On Artifice and Intelligence. Medium. https://medium.com/@shlomi.sher/on-artifice-and-intelligence-f19224281bee

Tan, Z., Beigi, A., Wang, S., Guo, R., Bhattacharjee, A., Jiang, B., Karami, M., Li, J., Cheng, L., & Liu, H. (2024). Large Language Models for Data Annotation: A Survey (arXiv:2402.13446). arXiv. https://doi.org/10.48550/arXiv.2402.13446

Touvron, H., Martin, L., Stone, K., Albert, P., Almahairi, A., Babaei, Y., Bashlykov, N., Batra, S., Bhargava, P., Bhosale, S., Bikel, D., Blecher, L., Ferrer, C. C., Chen, M., Cucurull, G., Esiobu, D., Fernandes, J., Fu, J., Fu, W., Scialom, T. (2023). Llama 2: Open Foundation and Fine-Tuned Chat Models (arXiv:2307.09288). arXiv. https://doi.org/10.48550/arXiv.2307.09288

Underwood, T. (2023, Juni 29). The Empirical Triumph of Theory. Critical Inquiry – AI Forum. https://critinq.wordpress.com/2023/06/29/the-empirical-triumph-of-theory/

Wolfram, S. (2023, Februar 14). What Is ChatGPT Doing … and Why Does It Work? Stephen Wolfram Writings. https://writings.stephenwolfram.com/2023/02/what-is-chatgpt-doing-and-why-does-it-work/

Zhao, W. X., Zhou, K., Li, J., Tang, T., Wang, X., Hou, Y., Min, Y., Zhang, B., Zhang, J., Dong, Z., Du, Y., Yang, C., Chen, Y., Chen, Z., Jiang, J., Ren, R., Li, Y., Tang, X., Liu, Z., & Wen, J.-R. (2023). A Survey of Large Language Models (arXiv:2303.18223). arXiv. https://doi.org/10.48550/arXiv.2303.18223